Le référencement dit « naturel » des sites internet, n’est plus favorisé aujourd’hui par une quelconque supériorité technique, un savoir faire de sorciers, ou encore lié un accès privilégié à quelques recettes secrètes du référencement.

Les techniques de référencement ont été détrônées, au profit de la pertinence réelle des contenus des sites. Ce qui implique l’inutilité progressive et programmée des outils d’optimisation et autre solutions d’optimisation SEO (Search Engine Optimization).

Bien sur, rien ne remplace le savoir-faire et l’expérience devenue indispensable d’un web architecte, compétant et conscient de l’indispensable qualité des contenus à référencer, rien ne remplace l’originalité et la pertinence rédactionnelle, la structure sémantique et l’accessibilité faciles des contenus.

C’est bien ici l’énumération et le retour des fondamentaux, remis en avant comme critères de qualité d’un site, qui aura alors après analyse d’un robot et de son intelligence artificielle toutes les chances d’être mis en avant dans les futures résultats de recherches.

Depuis à peu près 2019, les robots indexeurs de site pour moteur de recherche (et particulièrement celui de Google) ont été réglés autrement.

L’intelligence artificielle des Googlebot et autres machines de lecture de site a été éduquée afin de simuler et privilégier une navigation et une appréciation humaine des sites visités. Ainsi le célèbre google PageRank et l’indexation des pages sont présentement cantonnés à des critères de visibilité, de pertinence de contenus et d’appréciations humaines, et non pas liés à de potentiel truchements techniques, de codes plus ou moins masqués (balises meta), ou d’autres techniques finalement détournés de la pertinence, de l’intérêt et de la facilité d’accès réelles des contenus à indexer.

Combien même les anciennes méthodes essentiellement techniques seraient devenues contre productives pour le référencement, voir même pénalisantes, du fait que les référenceurs considèrent à présent que l’appui de techniques ne peut être un palliatif à un manque de pertinence ou à la pauvreté ou encore à la redondance d’un contenu, ou pour finir palier une mauvaise structure sémantique d’un site.

En réponse à ces changement conséquents, le plus célèbre et répandu des gestionnaires de contenus, à savoir le CMS WordPress, a répondu sans attendre par l’ajout (depuis la version 5.5) d’une fonctionnalité de pré-indexation en temps réelle, assurant la régénération automatique du mappage des liens vers les article et pages du site, ce en plaçant à la racine du site les fichier robot.txt et /wp-sitemap.xml. WordPress par cette fonctionnalité respecte l’efficacité par la simplicité exigée des nouvelles règles et l’intelligence réajustée des robots indexeurs. Une pré-indexation concocté par Automattic, au plus simple du contenu, laissant à l’intelligence artificielle du robot indexeur d’apprécier par des critères de lecture humaine, la qualité réelle des contenus à indexer.

Le dernier cri de Yoast.

Le plugin SEO Yoast pour WordPress, un des plus connus dans sa catégorie n’a visiblement pas bien intégré ces nouveautés techniques. Ainsi si vous installez ce plugin SEO Yoast, les fonctionnalités WordPress d’origine de génération du wp-sitemap.xml sont désactivées et Yoast prend la main dessus. Jusque là tout semble normal.

Le problème vient ensuite, après sa désactivation ou à la désinstallation de Yoast, lorsque le plugin ne restitue pas et bloque la fonctionnalité d’origine. Obligeant ainsi les administrateurs de WordPress à continuer à utiliser Yoast contre leur volonté, en leur forçant la main pour garantir au minimum la génération du fichier de mappage non wordpress: sitemap-index.xml

Revenir aux fonctionnalités de sitemap d’origine après la désactivation et la désinstallation de Yoast.

La correction de ce problème demande l’accès à la base de données de votre WordPress, par exemple par phpMyAdmin ou un outil similaire, ou encore directement en mode SSH en ligne de commande SQL sur le serveur de données.

– Commencez par faire une sauvegarde de la base de données du site en question.

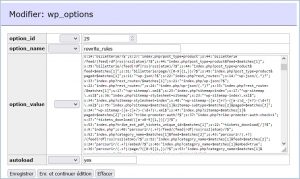

– Il faut ensuite travailler dans la table wp_options, et modifier la ligne rewrite_rules :

Trouver la mauvaise redirection contenant les chaîne de caractères « sitemap_index\.xml » et celle typiquement de Yoast.

– Plusieurs variables sont a enlever afin de retrouver l’ancienne redirection d’origine wp-sitemap \.xml

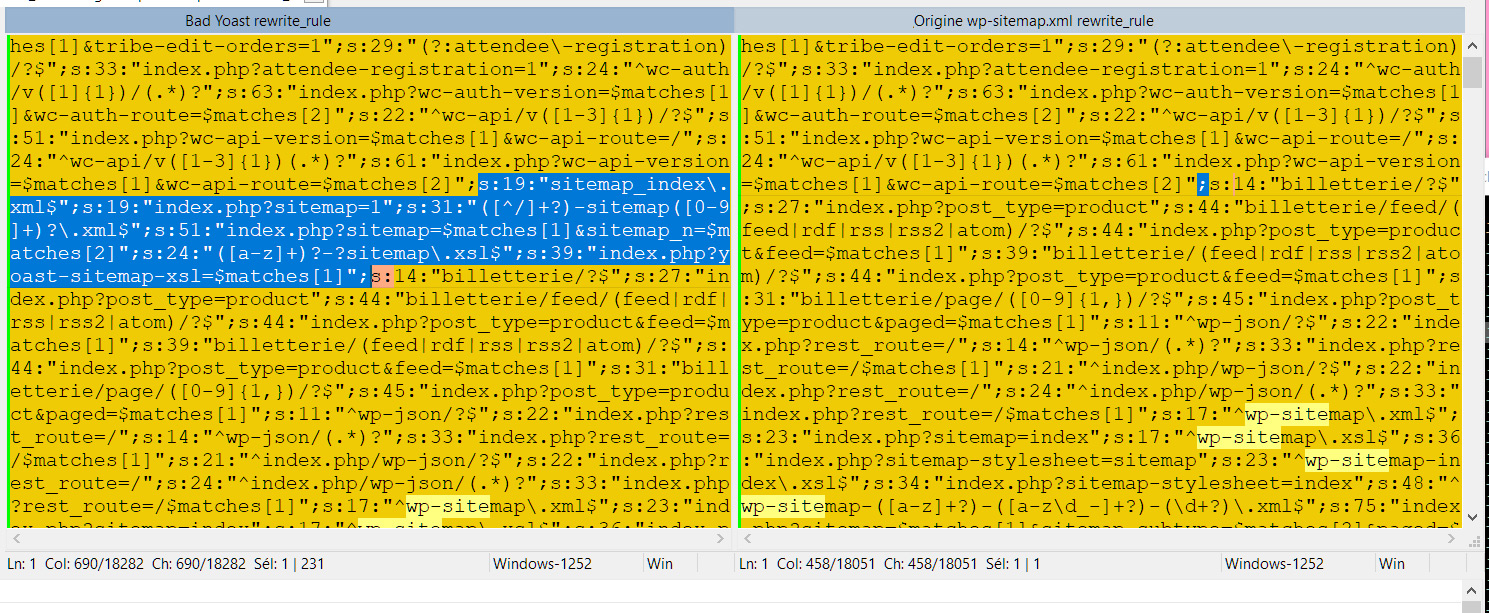

Notre exemple ci-dessous montre l’ensemble des variables d’expression régulières et les chaînes attachées à Yoast à supprimer.

Notez que le chiffre (xx) suivant le « s:XX » indique le nombre de caractères de la chaine (variable contenant l’expression régulière qui suis.

Dans le cas en exemple nous avons nettoy en supprimant 6 variables liées à Yoast de la ligne nommée rewrite_rules de la table wp_options

s:19:"sitemap_index\.xml$";s:19:"index.php?sitemap=1";s:31:"([^/]+?)-sitemap([0-9]+)?\.xml$";s:51:"index.php?sitemap=$matches[1]&sitemap_n=$matches[2]";s:24:"([a-z]+)?-?sitemap\.xsl$";s:39:"index.php?yoast-sitemap-xsl=$matches[1]";

En bleu ce qui a été supprimer afin de supprimer la redirection de Yoast (sitemap-index.xml) et retrouver le fichier d’origine wp-sitemap.xml

En bleu ce qui a été supprimer afin de supprimer la redirection de Yoast (sitemap-index.xml) et retrouver le fichier d’origine wp-sitemap.xml

Le rédactionnel est un métier

Faisant parties des compétences garantissant la bonne expérience des utilisateurs, l’architecture sémantique et le rédactionnel d’un portail internet sont exclusivement et fondamentalement la garantie d’un bon référencement et son indexation.

A ce propos, appuyé par une expérience depuis l’origine du web, Nicolas Reznikoff sera en mesure d’améliorer de façon concluante et de garantir le bon référencement de votre projet de site et portail web.